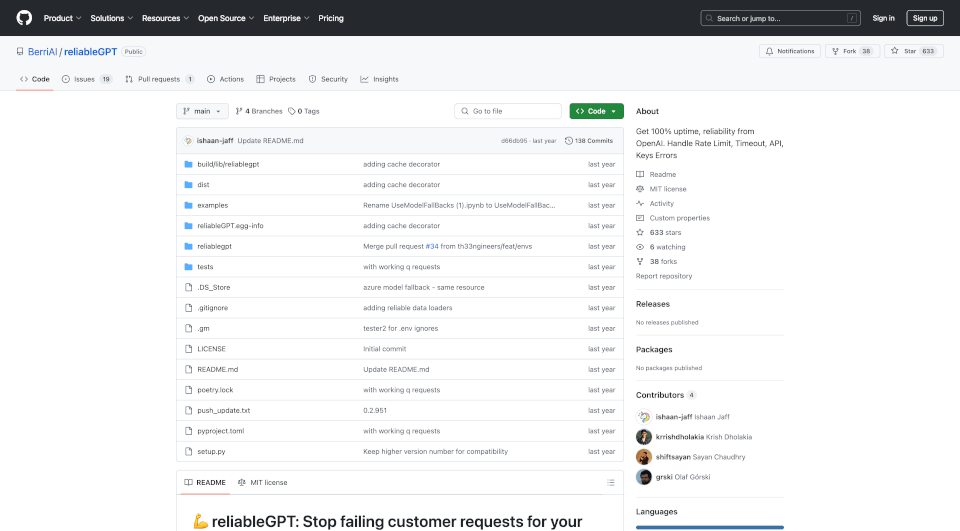

什么是ReliableGPT?

reliableGPT 是一款强大的解决方案,旨在确保使用 OpenAI 服务的应用程序实现 100% 的正常运行时间和可靠性。通过有效处理常见问题,如速率限制、超时和 API 错误,reliableGPT 提升了大型语言模型 (LLM) 应用程序的性能,确保持续的服务交付而不出现中断。

ReliableGPT的核心功能有哪些?

保证正常运行时间:reliableGPT 通过实施回退机制消除请求丢失,利用多个 OpenAI 模型实现。如果某个模型失败,系统将重试其他选项,如 GPT-4、GPT-3.5 和 text-davinci-003,确保请求及时完成。

上下文窗口管理:在出现上下文窗口错误的情况下,reliableGPT 智能地重试使用具有更大上下文窗口的模型,从而防止操作瓶颈。

缓存功能:该工具提供 缓存功能,基于语义相似性存储响应。在高流量实例或服务经历拥堵时,此功能能够让响应更加及时。

错误处理与备份策略:用户可以定义自定义回退策略并指定备份令牌以使用他们的 OpenAI 密钥。当发生无效密钥错误时,此功能通过轮换存储的密钥,确保服务的无缝连续性。

社区支持与入职培训:reliableGPT 拥有一个支持性的社区。用户可通过 Discord 或电子邮件寻求帮助,促进用户体验的协作环境。

ReliableGPT的特性是什么?

集成简易:将 reliableGPT 纳入现有应用程序几乎不需要任何努力。开发者只需一行代码即可无缝集成此解决方案。

高级用法:该产品支持额外参数进行量身定制的使用,包括线程管理和高级缓存功能,允许根据特定应用需求进行自定义部署。

全面文档:结构良好的资源指南帮助用户导航设置和故障排除,使其对新手与经验丰富的开发者都易于接触。

定期更新:reliableGPT 会不断进行增强,更新功能并解决用户在实时中遇到的新挑战。

ReliableGPT的使用案例有哪些?

高流量应用:对于经历用户互动高峰的平台,reliableGPT 确保所有查询都能有效管理,减少请求丢失的可能性,保持高服务质量。

基于 AI 的客户支持:采用 LLM 进行客户服务的公司可以利用 reliableGPT 确保每个客户咨询都能获得答复,即使在系统超载或遇到 API 错误时。

数据驱动决策:利用 AI 进行分析和报告的组织可以受益于其工具的增强可靠性,从而不间断地获取关键商业洞察。

访问多个模型:开发人员可以创建应用程序,根据可用性动态切换不同模型,优化性能与成本效益。

如何使用ReliableGPT?

-

安装:用户可以通过运行以下命令来开始使用 reliableGPT:

pip install reliableGPT -

基本配置:使用以下代码将 reliableGPT 集成到您的应用程序中:

from reliablegpt import reliableGPT openai.ChatCompletion.create = reliableGPT(openai.ChatCompletion.create, user_email='[email protected]') -

自定义回退策略:用户可以定义他们的回退策略,以进一步增强可靠性。例如:

fallback_strategy = ["gpt-3.5-turbo", "gpt-4", "text-davinci-003"] -

激活缓存:要启用缓存功能,只需将缓存参数设置为 true:

openai.ChatCompletion.create = reliableGPT(openai.ChatCompletion.create, caching=True) -

错误监控:如果出现错误率激增,用户将通过电子邮件收到警报,确保及时管理问题。

ReliableGPT联系邮箱:

如需查询或支持,可通过以下邮箱联系创始人: