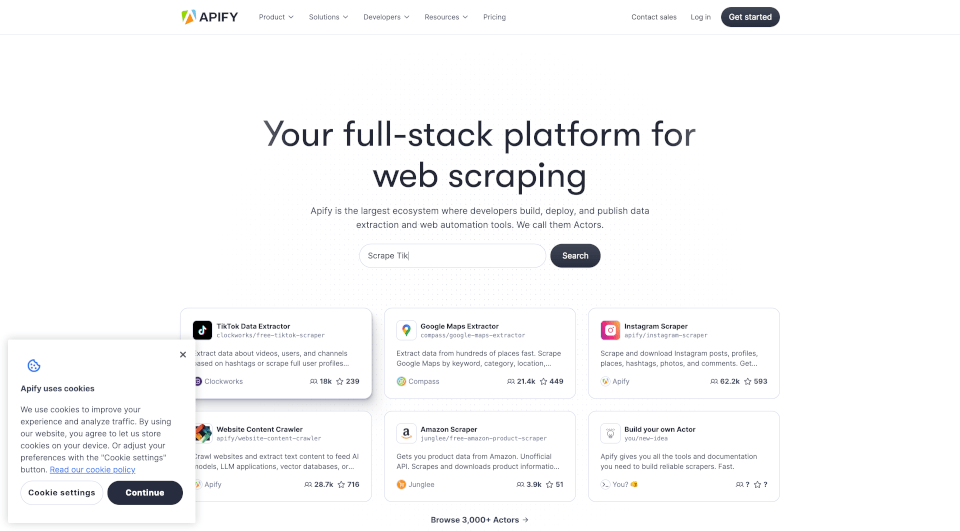

Qu'est-ce que Apify ?

Apify est une plateforme complète de web scraping et d'extraction de données conçue pour donner aux développeurs et aux entreprises les outils nécessaires pour rassembler et utiliser efficacement les données du web. Avec une infrastructure basée sur le cloud, Apify offre une expérience fluide pour le web scraping, l'automatisation de navigateur et le traitement des données, en faisant un outil essentiel pour quiconque cherchant à exploiter la puissance des données web pour diverses applications.

Quelles sont les caractéristiques de Apify ?

- Plus de 2 000 outils prêts à l'emploi : Apify propose une vaste bibliothèque de scrapers web préconstruits, appelés Acteurs, qui peuvent être utilisés pour extraire des données de sites web populaires rapidement et efficacement.

- Solutions personnalisées : Les utilisateurs peuvent commander des solutions de scraping personnalisées adaptées à leurs besoins spécifiques, garantissant qu'ils obtiennent les données exactes dont ils ont besoin.

- Programmes sans serveur : Créez et exécutez des programmes sans serveur qui s'adaptent automatiquement, permettant aux utilisateurs de se concentrer sur l'extraction de données sans se soucier de l'infrastructure.

- Intégrations : Apify se connecte facilement à diverses applications et services, y compris Zapier, Google Sheets et GitHub, améliorant ainsi son utilité et sa fonctionnalité.

- Proxy anti-blocage : La plateforme comprend des fonctionnalités pour faire tourner les adresses IP, aidant à éviter la détection et le blocage par les sites web cibles.

- Crawlee open source : La propre bibliothèque de scraping et de crawling d'Apify, Crawlee, est open source et prend en charge plusieurs langages de programmation, y compris Python et JavaScript.

- Stockage de données : Les utilisateurs peuvent stocker facilement les résultats de leurs scrapers web, garantissant que les données sont organisées et accessibles pour une utilisation future.

- Surveillance et planification : Apify permet aux utilisateurs de planifier des tâches de scraping et de surveiller leur performance, fournissant des informations sur les processus de collecte de données.

Quelles sont les caractéristiques de Apify ?

Apify se distingue par son interface conviviale et ses capacités robustes. La plateforme est conçue pour les débutants comme pour les développeurs expérimentés, offrant une gamme de modèles de code en Python, JavaScript et TypeScript pour aider les utilisateurs à démarrer rapidement. L'intégration de fonctionnalités avancées telles que les proxies anti-blocage et l'architecture sans serveur en fait un choix fiable pour les entreprises de toutes tailles.

Quels sont les cas d'utilisation de Apify ?

- Données pour l'IA générative : Apify peut être utilisé pour rassembler de grands ensembles de données nécessaires à l'entraînement de modèles d'IA, permettant aux entreprises de tirer parti de l'IA pour diverses applications.

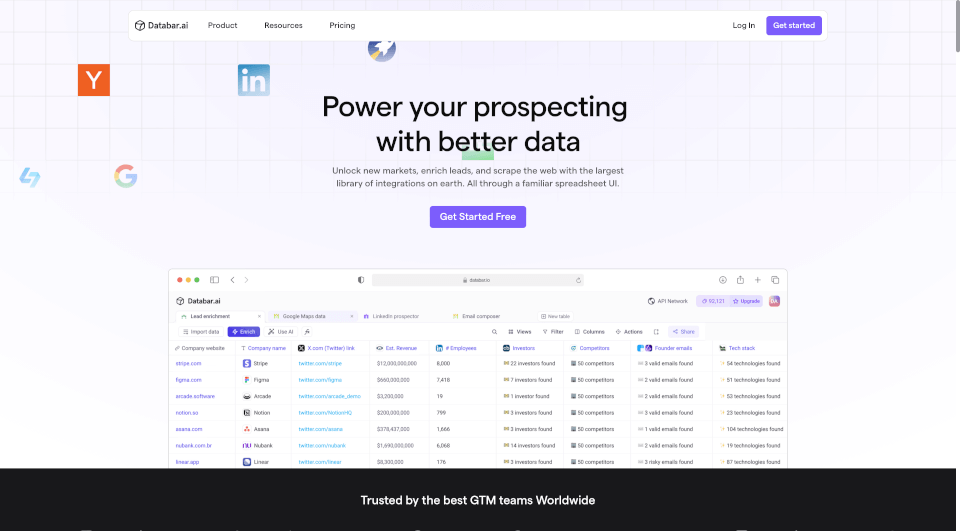

- Génération de leads : Les entreprises peuvent utiliser Apify pour extraire des données des plateformes de médias sociaux et des sites web afin de générer des leads et d'améliorer leurs stratégies marketing.

- Recherche de marché : Les entreprises peuvent collecter des données sur les concurrents, les tendances du marché et le comportement des consommateurs pour informer leurs stratégies et processus de prise de décision.

- Analyse de sentiment : En extrayant des avis et des publications sur les réseaux sociaux, les entreprises peuvent analyser le sentiment public envers leurs produits ou services, les aidant à améliorer la satisfaction client.

- Curation de contenu : Apify peut être utilisé pour rassembler du contenu provenant de diverses sources, permettant aux entreprises de sélectionner des informations pertinentes pour leurs audiences.

Comment utiliser Apify ?

Pour commencer avec Apify, les utilisateurs peuvent s'inscrire pour un compte sur la plateforme. Une fois enregistrés, ils peuvent explorer le magasin Apify pour trouver des Acteurs prêts à l'emploi ou créer les leurs en utilisant la documentation et les modèles de code fournis. Les utilisateurs peuvent déployer leurs scrapers en utilisant l'interface en ligne de commande ou l'intégration GitHub, facilitant ainsi la gestion et l'exécution des tâches de scraping.