Was ist Fireworks?

Fireworks AI revolutioniert die Landschaft der generativen KI mit seiner schnellsten Inferenz-Engine, die sowohl für LLMs als auch für Bildmodelle konzipiert ist. Durch den Einsatz modernster Technologie ermöglicht Fireworks AI den Nutzern, blitzschnelle Geschwindigkeiten zu erleben und gleichzeitig die Flexibilität zu bieten, benutzerdefinierte Modelle ohne zusätzliche Kosten anzupassen und bereitzustellen. Mit dem kürzlichen Start von Llama 3.3 70B Instruct können die Nutzer nun von verbessertem Denken, verbesserten mathematischen Fähigkeiten und überlegenen Anweisungsbefolgungsfunktionen profitieren.

Was sind die Merkmale von Fireworks?

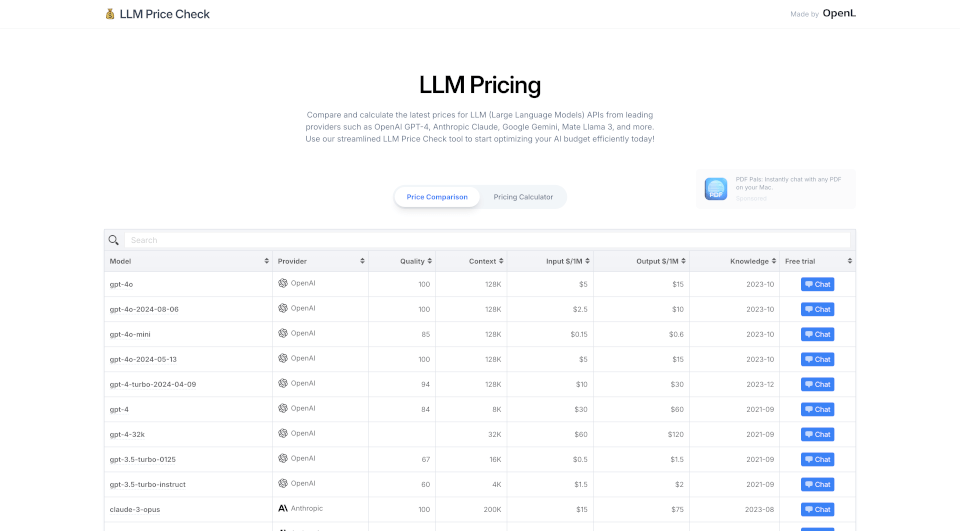

- Geschwindigkeit und Effizienz: Fireworks AI bietet eine 9x schnellere RAG im Vergleich zu traditionellen Modellen und 6x schnellere Bildgenerierung als andere Anbieter. Mit der Fähigkeit, 1000 Tokens pro Sekunde mithilfe von spekulativer Dekodierung zu verarbeiten, setzt es einen neuen Standard in der Branche.

- Kosten-Effektivität: Nutzer können von 40x niedrigeren Kosten für Chat-Modelle wie Llama3 auf Fireworks im Vergleich zu GPT-4 profitieren, was es zu einer wirtschaftlichen Wahl für Unternehmen macht, die KI-Lösungen implementieren möchten.

- Hohe Durchsatzrate: Fireworks AI bietet 15x höheren Durchsatz mit FireAttention im Vergleich zu vLLM, sodass die Nutzer große Datenmengen verarbeiten können, ohne die Leistung zu beeinträchtigen.

- Skalierbarkeit: Mit der Fähigkeit, 140B+ Tokens und 1M+ Bilder pro Tag zu generieren, ist Fireworks AI für Skalierung ausgelegt und bietet 99,99% Betriebszeit über 100+ Modelle.

- Anpassbare Bereitstellung: Die Plattform ermöglicht eine serverlose Bereitstellung, die es den Nutzern ermöglicht, schnell zu starten und nach Token zu bezahlen, was ideal für Entwickler ist, die ohne Vorabverpflichtungen skalieren möchten.

Was sind die Eigenschaften von Fireworks?

Fireworks AI zeichnet sich durch seine disaggregierte Servierarchitektur aus, die die Leistung durch semantisches Caching und spekulative Dekodierung verbessert. Dieser innovative Ansatz ermöglicht das sofortige Ausführen beliebter Modelle wie Llama3, Mixtral und Stable Diffusion, die alle für maximale Latenz, Durchsatz und Kontextlänge optimiert sind. Der benutzerdefinierte FireAttention CUDA-Kernel bedient Modelle viermal schneller als vLLM und gewährleistet qualitativ hochwertige Ausgaben ohne Verzögerungen.

Was sind die Anwendungsfälle von Fireworks?

Fireworks AI ist vielseitig einsetzbar und kann in verschiedenen Bereichen angewendet werden, darunter:

- Chatbots und Virtuelle Assistenten: Verbessern Sie die Benutzerinteraktion mit reaktionsschnellen und intelligenten Chat-Modellen.

- Inhaltserstellung: Generieren Sie hochwertige Texte und Bilder für Marketing, soziale Medien und kreative Projekte.

- Datenanalyse: Nutzen Sie KI für die schnelle Datenverarbeitung und Generierung von Erkenntnissen, was für Unternehmen von unschätzbarem Wert ist.

- Gesundheitswesen: Implementieren Sie KI-gesteuerte Lösungen für medizinische Datenanalyse, Diagnosen und Patienteninteraktion.

- Bildung: Erstellen Sie personalisierte Lernerfahrungen durch intelligente Tutoring-Systeme und die Generierung von Bildungsinhalten.

Wie benutzt man Fireworks?

Um mit Fireworks AI zu beginnen, befolgen Sie diese einfachen Schritte:

- Dataset erstellen: Verwenden Sie den Befehl

firectl create dataset my-dataset path/to/dataset.jsonl, um Ihre Daten hochzuladen. - Modell anpassen: Starten Sie einen Feinabstimmungsjob mit

firectl create fine-tuning-job --settings-file path/to/settings.yaml. - Modell bereitstellen: Stellen Sie Ihr feinabgestimmtes Modell mit

firectl deploy my-modelbereit. - Experimentieren und Iterieren: Wechseln Sie zwischen bis zu 100 feinabgestimmten Modellen, um die Leistung zu optimieren, ohne zusätzliche Kosten zu verursachen.