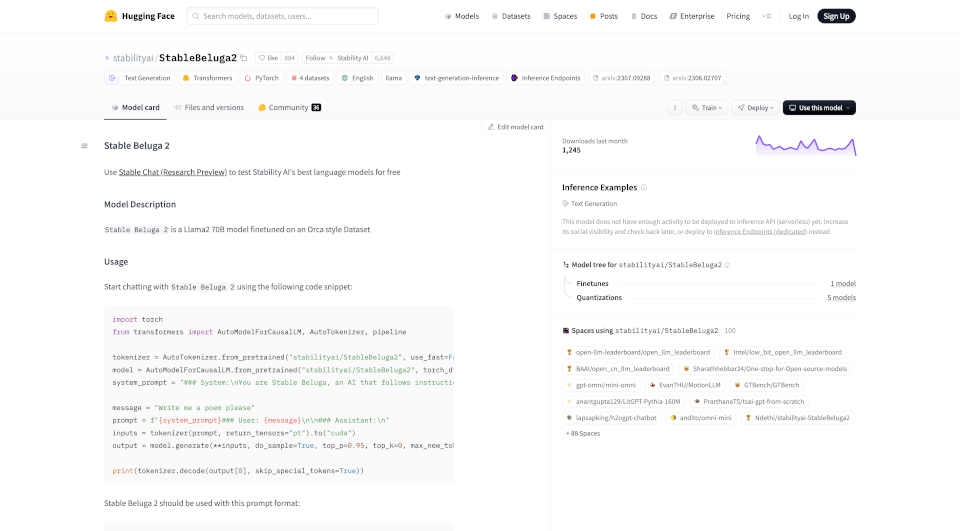

¿Qué es StableBeluga2?

Stable Beluga 2 es la última innovación de Stability AI, diseñado como un modelo de lenguaje autorregresivo afinado sobre la extensa arquitectura Llama2 de 70B. Con una base sólida derivada de algoritmos avanzados, este modelo tiene como objetivo proporcionar a los usuarios capacidades de generación de texto altamente precisas y contextualmente conscientes. Ya sea creando poemas, generando artículos informativos o asistiendo en la escritura creativa, Stable Beluga 2 promete un rendimiento y adaptabilidad inigualables.

¿Cuáles son las características de StableBeluga2?

- Procesamiento Avanzado del Lenguaje: Construido sobre la arquitectura Llama2, Stable Beluga 2 sobresale en la comprensión y generación de texto similar al humano, gracias a sus metodologías de aprendizaje profundo.

- Entrenamiento en Dataset al Estilo Orca: El modelo está finamente ajustado utilizando un conjunto de datos al estilo Orca, lo que mejora su capacidad para seguir instrucciones complejas y producir resultados coherentes.

- Prompts Conversacionales Dinámicos: Los usuarios pueden interactuar con el modelo utilizando una estructura de prompts simple, facilitando conversaciones atractivas e intercambios creativos.

- Consideraciones de Seguridad y Ética: Reconociendo los desafíos que plantea la tecnología AI, Stability AI ha integrado medidas para mitigar los riesgos de generar contenido sesgado o inapropiado, instando a los desarrolladores a realizar las pruebas de seguridad necesarias antes del despliegue de aplicaciones.

- Alta Eficiencia: Optimizado para el rendimiento, el modelo utiliza técnicas de entrenamiento avanzadas como la optimización AdamW y el entrenamiento de precisión mixta para asegurar un uso eficiente de los recursos computacionales.

¿Cuáles son las características de StableBeluga2?

Stable Beluga 2 se destaca debido a sus características únicas, incluyendo:

- Tamaño y Escala: Como un modelo de 70 mil millones de parámetros, posee la capacidad de generar salidas de texto intrincadas y matizadas.

- Diseño Centrado en el Usuario: El prompt del sistema fomenta que el modelo se comporte de manera instructiva, posicionándolo como un asistente ideal para usuarios que requieren ayuda en diversas tareas.

- Procedimiento de Entrenamiento Innovador: La implementación de metodologías de entrenamiento de vanguardia asegura que el modelo aprenda de manera efectiva de conjuntos de datos diversos, mejorando su versatilidad en diferentes tareas lingüísticas.

¿Cuáles son los casos de uso de StableBeluga2?

Las diversas capacidades de Stable Beluga 2 abren puertas a numerosos escenarios de aplicación, tales como:

- Creación de Contenido: Ideal para blogueros, mercadólogos y escritores de contenido que buscan asistencia para generar artículos, publicaciones de blog y material de marketing de alta calidad.

- Herramientas Educativas: Proporciona a estudiantes y educadores una herramienta confiable para generar contenido educativo, resúmenes e incluso explicaciones complejas de temas.

- Ayuda en Escritura Creativa: Asiste a autores en la lluvia de ideas, escritura de poesía o refinamiento de prosa mediante el compromiso conversacional.

- Desarrollo de Chatbots: Mejora la interacción del usuario en sistemas de atención al cliente o plataformas de servicio, proporcionando respuestas instantáneas que se alinean con las consultas de los usuarios.

- Asistencia en Investigación: Ayuda a los investigadores a generar resúmenes de documentos académicos, propuestas o esquemas de proyectos de manera rápida y precisa.

¿Cómo usar StableBeluga2?

Para interactuar con Stable Beluga 2, sigue estos simples pasos:

- Importa las bibliotecas y el modelo necesarios utilizando el fragmento de código proporcionado.

- Define un prompt del sistema que establezca el contexto para la interacción.

- Formula tu consulta o tarea como un mensaje de usuario.

- Pasa ambos prompts al modelo para que genere una respuesta.

- Decodifica y muestra la salida para ver el texto generado.

Fragmento de Código de Ejemplo:

import torch

from transformers import AutoModelForCausalLM, AutoTokenizer, pipeline

tokenizer = AutoTokenizer.from_pretrained("stabilityai/StableBeluga2", use_fast=False)

model = AutoModelForCausalLM.from_pretrained("stabilityai/StableBeluga2", torch_dtype=torch.float16, low_cpu_mem_usage=True, device_map="auto")

system_prompt = "### Sistema:\nEres Stable Beluga, una IA que sigue instrucciones extremadamente bien. Ayuda tanto como puedas. Recuerda, sé seguro y no hagas nada ilegal.\n\n"

message = "Escríbeme un poema por favor"

prompt = f"{system_prompt}### Usuario: {message}\n\n### Asistente:\n"

inputs = tokenizer(prompt, return_tensors="pt").to("cuda")

output = model.generate(**inputs, do_sample=True, top_p=0.95, top_k=0, max_new_tokens=256)

print(tokenizer.decode(output[0], skip_special_tokens=True))

Información de la empresa StableBeluga2:

Stability AI es un líder en el campo de la inteligencia artificial, centrado en crear y promover tecnologías de código abierto que empoderan a desarrolladores y empresas a nivel mundial. Su objetivo es avanzar y democratizar la IA a través de principios de ciencia abierta.

Correo electrónico de contacto StableBeluga2:

Para consultas relacionadas con Stable Beluga 2, por favor contacta: [email protected]