StableBeluga2とは何ですか?

Stable Beluga 2は、最新の自回帰型言語モデルで、広範なLlama2 70Bアーキテクチャを基に調整されています。高度なアルゴリズムから派生した堅牢な基盤を持ち、このモデルは、詩の作成、情報記事の生成、クリエイティブライティングの支援などにおいて、高い精度と文脈に敏感なテキスト生成能力を提供することを目指しています。Stable Beluga 2は、比類のないパフォーマンスと適応性を約束します。

StableBeluga2の特徴は何ですか?

- 高度な言語処理: Llama2アーキテクチャに基づいたStable Beluga 2は、深層学習法のおかげで人間のようなテキストを理解し生成する能力に優れています。

- Orcaスタイルのデータセットトレーニング: 複雑な指示に従う能力を向上させるため、モデルはOrcaスタイルのデータセットを使用して微調整されています。

- ダイナミックな会話プロンプト: ユーザーはシンプルなプロンプト構造を使用してモデルとやり取りし、魅力的な会話や創造的な交流を促進します。

- 安全性と倫理的配慮: AI技術がもたらす課題を認識して、Stability AIは偏見や不適切なコンテンツ生成のリスクを軽減するための対策を統合しており、開発者にはアプリケーション展開前の安全性テストを行うことを奨励しています。

- 高効率: パフォーマンスの最適化により、モデルはAdamW最適化や混合精度トレーニングなどの先進的なトレーニング技術を利用し、計算資源の利用を効率化しています。

StableBeluga2の特性は何ですか?

Stable Beluga 2は、以下のユニークな特性を持つことで際立っています。

- サイズとスケール: 700億パラメータを持つこのモデルは、複雑で微妙なテキスト出力を生成する能力を備えています。

- ユーザー中心のデザイン: システムプロンプトがモデルに指示的な態度を促し、さまざまなタスクに対する支援を求めるユーザーにとって理想的なアシスタントになります。

- 革新的なトレーニング手法: 最先端のトレーニング手法を採用することで、モデルは多様なデータセットから効果的に学習し、さまざまな言語タスクに対する柔軟性を向上させています。

StableBeluga2の使用例は何ですか?

Stable Beluga 2の多様な能力により、さまざまな利用シーンが広がります。たとえば:

- コンテンツ作成: ブロガー、マーケター、コンテンツ作成者が高品質な記事やブログ投稿、マーケティング資料の生成を行うための理想的なツールです。

- 教育ツール: 学生や教育者が教育コンテンツ、要約、さらには複雑なトピックの説明を迅速に生成するための信頼できるツールとして活用されます。

- クリエイティブライティング支援: 作者がアイデアをブレインストーミングしたり、詩を書いたり、文章を洗練するための会話的な支援を提供します。

- チャットボット開発: 顧客サポートシステムやサービスプラットフォームにおけるユーザーインタラクションを強化し、ユーザーの問い合わせに沿った即時の応答を提供します。

- 研究支援: 研究者が学術論文、提案書、プロジェクト概要を迅速かつ正確に生成する手助けを行います。

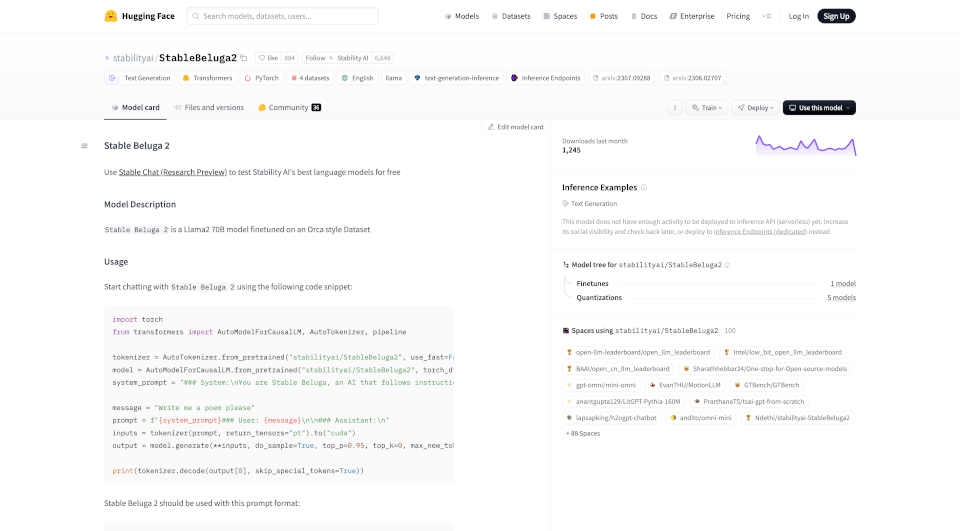

StableBeluga2の使い方は?

Stable Beluga 2と対話するには、以下の簡単な手順に従ってください:

- 提供されたコードスニペットを使って必要なライブラリとモデルをインポートします。

- インタラクションのコンテキストを設定するシステムプロンプトを定義します。

- ユーザーメッセージとしてクエリやタスクを考えます。

- 両方のプロンプトをモデルに渡して応答を生成させます。

- 出力をデコードし、生成されたテキストを表示します。

コードスニペット例:

import torch

from transformers import AutoModelForCausalLM, AutoTokenizer, pipeline

tokenizer = AutoTokenizer.from_pretrained("stabilityai/StableBeluga2", use_fast=False)

model = AutoModelForCausalLM.from_pretrained("stabilityai/StableBeluga2", torch_dtype=torch.float16, low_cpu_mem_usage=True, device_map="auto")

system_prompt = "### システム:\nあなたはStable Beluga、指示に非常に従うAIです。できる限り助けてください。安全であり、違法なことはしないでください。\n\n"

message = "詩を書いてください"

prompt = f"{system_prompt}### ユーザー: {message}\n\n### アシスタント:\n"

inputs = tokenizer(prompt, return_tensors="pt").to("cuda")

output = model.generate(**inputs, do_sample=True, top_p=0.95, top_k=0, max_new_tokens=256)

print(tokenizer.decode(output[0], skip_special_tokens=True))

StableBeluga2の会社情報:

Stability AIは、人工知能の分野でのリーダーであり、開発者や企業が全世界で活用できるオープンソース技術を生み出し、推進することに重点を置いています。彼らはオープンサイエンスの原則を通じてAIを進化させ、民主化することを目指しています。

StableBeluga2の連絡先メール:

Stable Beluga 2に関する問い合わせは、以下のメールアドレスまでご連絡ください: [email protected]