什么是Baseten?

Baseten 是一个先进的模型部署平台,旨在简化生产中 AI 模型的服务过程。它强调性能、安全性和愉悦的开发者体验,赋能数据科学家和工程师专注于构建创新的 AI 应用,而无需担心基础设施管理。它支持多种框架的模型,方便无缝集成并迅速扩展以满足用户需求。

Baseten的核心功能有哪些?

高性能推理: Baseten 提供令人印象深刻的模型吞吐量,达到每秒 1500 个标记,并确保低延迟,首次 Token 的响应时间通常低于 100 毫秒。

轻松的自动扩展: 平台的自动扩展器会根据传入的流量自动调整模型副本数量,使企业在维持性能的同时,不必为计算资源支付过高费用。

开源模型打包(Truss): Truss 是一个跨框架的开源标准,用于打包机器学习模型,使团队更易于共享和部署它们的模型,无论是在本地还是在生产环境中。

魔法冷启动优化: Baseten 优化了模型管道的各个阶段,从构建镜像到获取权重,大大缩短了冷启动时间。

资源管理和可观察性: 平台提供详细的日志管理、事件过滤和实时跟踪关键指标(如推理计数和 GPU 在线时间),确保操作顺利,快速解决问题。

Baseten的特性是什么?

企业级基础设施: Baseten 优先考虑安全、可靠性和合规性,适合对操作框架有强大需求的企业应用。单租户选项进一步增强安全性,通过在虚拟和物理上隔离模型。

全面的成本管理: 平台提供监控和优化支出的工具,使组织能够控制其基础设施成本,同时受益于高性能的部署。

灵活的部署选项: 无论是在组织的基础设施上部署,还是在 Baseten 的云中,平台都支持多种部署场景,为团队提供满足其操作需求的灵活性。

Baseten的使用案例有哪些?

实时 AI 应用: Baseten 非常适合为交互式应用(如聊天机器人、虚拟助手和翻译服务)提供支持,在用户满意度至关重要的情况下保持低延迟。

自定义模型开发: 数据科学家可以利用 Baseten 构建和部署针对独特业务挑战的特定领域模型,而无需担心底层基础设施管理。

快速原型开发和扩展: 其用户友好的环境便于快速部署原型模型,让公司能够测试新想法并根据反馈迅速迭代。

高容量推理负载: 需要处理大量模型预测的组织可以依赖 Baseten 的流线型自动扩展和优化功能,以在高负载下维持高性能。

如何使用Baseten?

要开始使用 Baseten,请按照以下简单步骤操作:

-

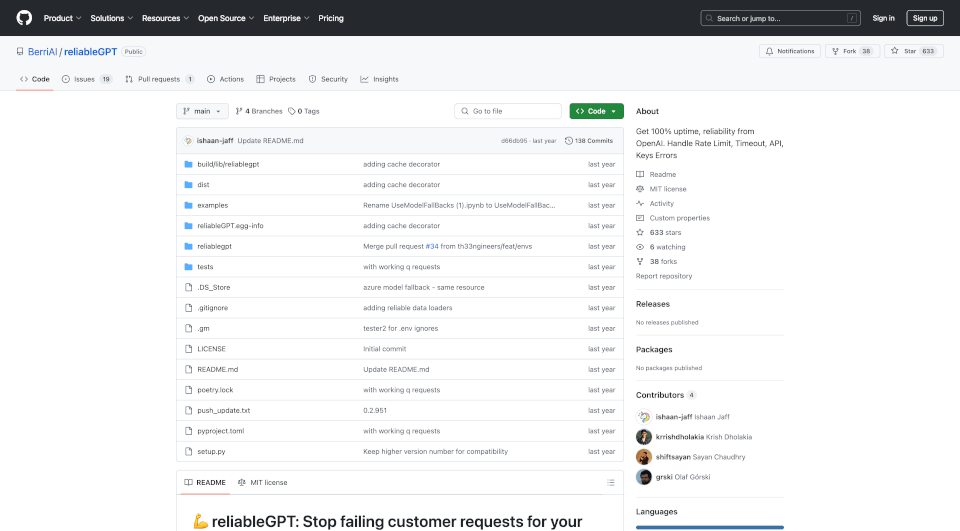

安装 Truss:

pip install --upgrade truss -

打包你的模型: 使用 Truss 创建配置文件并在 Python 中定义模型行为,以打包你的模型。

-

推送你的模型: 通过以下命令将模型上传至 Baseten:

truss push -

部署和扩展: 监控你的部署并配置自动扩展设置,以有效管理模型流量。

-

访问你的端点: 部署完成后,你的模型将通过自动生成的 API 端点可用,随时准备进行实时交互。