Was ist Berri?

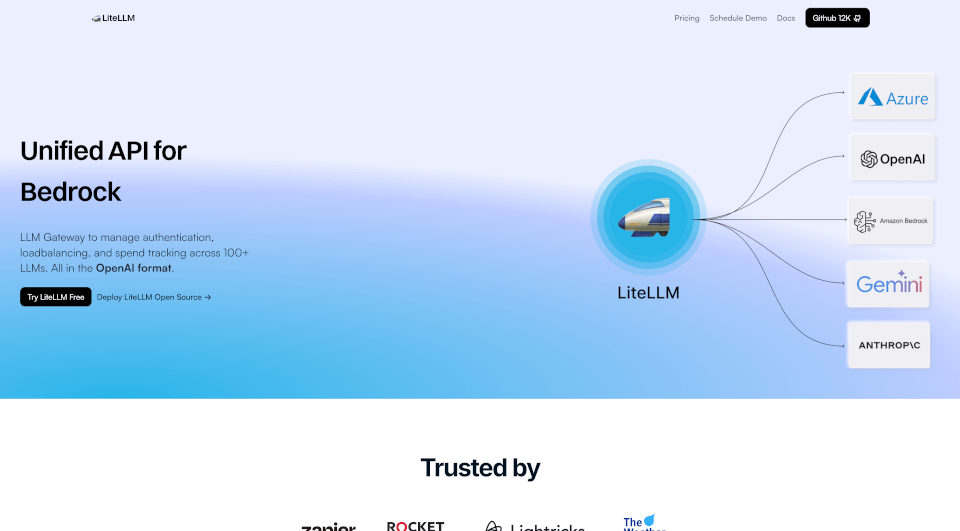

LiteLLM ist eine fortschrittliche Lösung, die das Management mehrerer Language Learning Models (LLMs) über eine einheitliche API optimiert. Mit Funktionen wie Lastverteilung, Fehlerfall-Handling und Kostenverfolgung steigert LiteLLM die Effizienz und ermöglicht eine nahtlose Integration mit über 100+ LLMs, einschließlich namhafter Anbieter wie OpenAI, Azure OpenAI, Vertex AI und Bedrock. Egal, ob Sie Entwickler, Datenwissenschaftler oder KI-Enthusiast sind, LiteLLM erleichtert die Nutzung modernster LLM-Technologie ohne die übliche Komplexität.

Was sind die Merkmale von Berri?

- Einheitliche API für mehrere Anbieter: LiteLLM bündelt verschiedene Modelle in einer einzigen API-Schnittstelle, wodurch Entwickler mit mehreren LLMs auf standardisierte Weise interagieren können.

- Lastverteilung: Diese Funktion optimiert die Verteilung von Anfragen über verschiedene LLMs, um eine gleichmäßige Leistung sicherzustellen und eine Überlastung bestimmter Modelle zu vermeiden.

- Fehlerfall-Handling: Im Falle eines API-Ausfalls leitet LiteLLM Anfragen automatisch an alternative Modelle um, um einen unterbrechungsfreien Betrieb zu gewährleisten.

- Kostenverfolgung: Verwenden Sie präzise Tools zur Verwaltung und Überwachung Ihrer Ausgaben für LLMs. LiteLLM bietet Werkzeuge zur Festlegung von Budgets und zur effektiven Kostenverfolgung.

- Virtuelle Schlüssel und Budgets: Generieren Sie virtuelle Schlüssel für verschiedene Teams oder Projekte und weisen Sie spezifische Budgets zu, um die Kosten effektiv zu verwalten.

- Überwachung und Protokollierung: Durch kontinuierliches Monitoring von Anfragen und Leistungen mit Integrationen für Langfuse, Langsmith und OpenTelemetry werden umfassende Analysen und Protokollierungen ermöglicht.

- Metriken und Authentifizierung: Unterstützt JWT-Authentifizierung, Single Sign-On (SSO) und Audit-Protokollierung, um Sicherheit und Compliance zu verbessern.

- Gemeinschaft und Einrichtungshilfe: Mit über 200 Mitwirkenden und einer florierenden Gemeinschaft ist Unterstützung für LiteLLM leicht verfügbar, um den Einrichtungsprozess reibungslos und ressourcenschonend zu gestalten.

Was sind die Eigenschaften von Berri?

LiteLLM hebt sich durch seine robuste Architektur und benutzerzentrierte Gestaltung in der sich schnell entwickelnden KI-Landschaft ab. Es zeichnet sich durch Folgendes aus:

- 100% Uptime-Garantie: Mit umfangreicher Infrastrukturunterstützung können Benutzer auf ununterbrochenen Zugriff auf LLM-Dienste vertrauen.

- Open Source Flexibilität: LiteLLM ist als Open-Source-Lösung verfügbar, was bedeutet, dass Benutzer es nach ihren Bedürfnissen anpassen und hosten können, um Flexibilität und Innovation zu fördern.

- Zuverlässigkeit bei hoher Nachfrage: Über 90.000 Downloads aus Docker und mehr als 20 Millionen bearbeitete Anfragen unterstreichen die Kapazität und das Vertrauen in LiteLLM innerhalb der Gemeinschaft.

- Nahtlose Integration: Durch die Bereitstellung einer einfachen, aber leistungsstarken einheitlichen API stellt LiteLLM sicher, dass Ihre Anwendungen problemlos mit verschiedenen LLMs verbunden werden können.

Was sind die Anwendungsfälle von Berri?

LiteLLM ist vielseitig und kann effektiv in mehreren Bereichen genutzt werden:

- Inhaltsgenerierung: Unternehmen können LiteLLM verwenden, um automatisch geschriebene Inhalte, Blogs, Marketingmaterialien und Produktbeschreibungen zu generieren und Zeit und Aufwand zu reduzieren.

- Konversationsagenten: Die Implementierung von LiteLLM in Chatbots oder virtuellen Assistenten steigert deren Reaktionsfähigkeit und Genauigkeit, indem sie Erkenntnisse aus verschiedenen LLMs ziehen.

- Datenanalyse: Forscher und Analysten können LiteLLM nutzen, um große Datenmengen zu synthetisieren und so die Entscheidungsfindung durch fortgeschrittene Analysen zu verbessern.

- Bildungs- und Lernwerkzeuge: Pädagogen können interaktive Lernangebote schaffen, indem sie LLMs integrieren, um sofortiges Feedback oder personalisierte Lernwege für Schüler bereitzustellen.

- Kreative Anwendungen: Künstler und Kreative können LiteLLM nutzen, um neue Ideen zu generieren, die Kreativität zu steigern und künstlerische Wege in Musik, Schreiben und visuellen Künsten zu erkunden.

Wie benutzt man Berri?

Um mit LiteLLM zu starten, folgen Sie diesen Schritten:

- LiteLLM installieren: Laden Sie LiteLLM über das offizielle Repository oder Docker herunter und installieren Sie es.

- Konto erstellen: Melden Sie sich auf der LiteLLM-Plattform an, um Zugang zu erhalten und API-Schlüssel zu erhalten.

- Anbieter konfigurieren: Wählen Sie Ihre bevorzugten LLM-Anbieter aus und konfigurieren Sie sie über das LiteLLM-Dashboard.

- Lastverteilung einrichten: Definieren Sie Ihre Präferenzen zur Lastverteilung, um die Anfragen optimal zu verteilen.

- API-Aufrufe implementieren: Nutzen Sie das LiteLLM-Python-SDK oder direkte API-Aufrufe in Ihrem Anwendungscode, um die LLM-Funktionen zu nutzen.

- Nutzung überwachen: Verfolgen Sie Ausgaben und Nutzung über das bereitgestellte Analyse-Dashboard, um optimale Leistung und Kostenwirksamkeit sicherzustellen.