Что такое Berri?

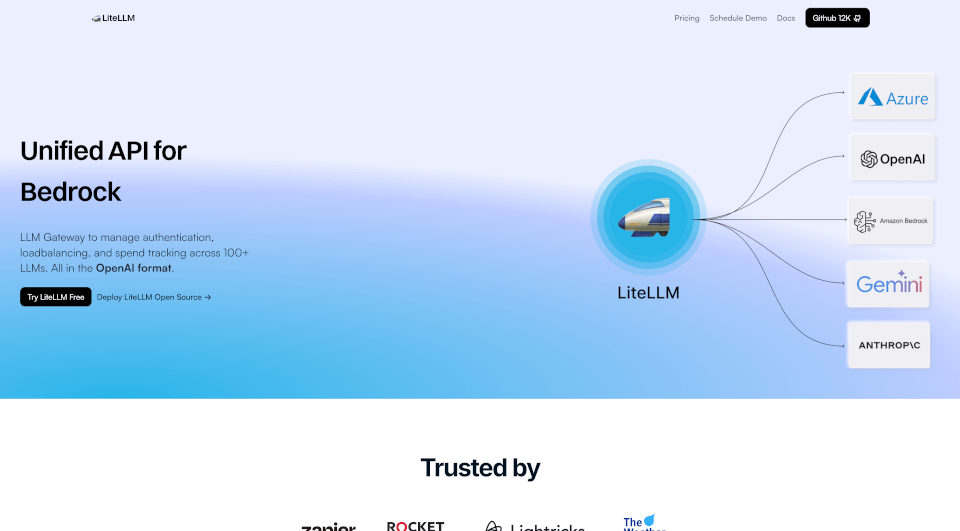

LiteLLM — это передовое решение, предназначенное для упрощения управления несколькими моделями машинного обучения (LLM) через единый API. С возможностями, которые поддерживают балансировку нагрузки, резервные механизмы и отслеживание затрат, LiteLLM повышает эффективность и предлагает бесшовную интеграцию с более чем 100+ LLM, включая известных провайдеров, таких как OpenAI, Azure OpenAI, Vertex AI и Bedrock. Независимо от того, являетесь ли вы разработчиком, ученым в области данных или энтузиастом ИИ, LiteLLM облегчает использование технологий передового поколения без обычной сложности.

Какие особенности у Berri?

- Единый API для множества провайдеров: LiteLLM агрегирует различные модели в едином интерфейсе API, позволяя разработчикам взаимодействовать с несколькими LLM стандартным образом.

- Балансировка нагрузки: Эта функция оптимизирует распределение запросов между различными LLM, чтобы обеспечить стабильную производительность и избежать перегрузки конкретных моделей.

- Резервные механизмы: В случае сбоя API LiteLLM автоматически перенаправляет запросы на альтернативные модели, обеспечивая непрерывную работу.

- Отслеживание затрат: Эффективно управляйте и контролируйте свои расходы на LLM. LiteLLM предлагает инструменты для установки бюджетов и точного отслеживания затрат.

- Виртуальные ключи и бюджеты: Генерируйте виртуальные ключи для разных команд или проектов и выделяйте определенные бюджеты для эффективного управления затратами.

- Мониторинг и ведение логов: Непрерывный мониторинг запросов и производительности с интеграциями для Langfuse, Langsmith и OpenTelemetry предоставляет полную аналитику и ведение логов.

- Метрики и аутентификация: Поддержка аутентификации JWT, единого входа (SSO) и ведения аудита для повышения безопасности и соблюдения норм.

- Поддержка сообщества и настройка: С более чем 200 участниками и процветающим сообществом, поддержка LiteLLM легко доступна, что делает процесс настройки гладким и ресурсоемким.

Какие характеристики у Berri?

LiteLLM выделяется на фоне быстро меняющегося ИИ-пейзажа благодаря своей надежной архитектуре и ориентированному на пользователя дизайну. Он характеризуется:

- Гарантия безотказной работы 100%: С обширной поддержкой инфраструктуры пользователи могут полагаться на непрерывный доступ к услугам LLM.

- Гибкость открытого кода: LiteLLM доступен как решение с открытым исходным кодом, что означает, что пользователи могут модифицировать и хостить его в соответствии со своими нуждами, способствуя адаптируемости и инновациям.

- Надежность в условиях высокого спроса: Более 90 000 загрузок из Docker и более 20 миллионов обработанных запросов подчеркивают возможности LiteLLM и доверие к нему внутри сообщества.

- Бесшовная интеграция: Предоставляя простой, но мощный единый API, LiteLLM обеспечивает легкое подключение ваших приложений к различным LLM без лишних хлопот.

Какие случаи использования Berri?

LiteLLM универсален и может эффективно использоваться в различных областях:

- Генерация контента: Бизнес может использовать LiteLLM для автоматической генерации письменного контента, блогов, маркетинговых материалов и описаний продуктов, сокращая время и усилия.

- Разговорные агенты: Внедрение LiteLLM в чат-боты или виртуальные помощники повышает их отзывчивость и точность, используя информацию из различных LLM.

- Анализ данных: Исследователи и аналитики могут использовать LiteLLM для синтеза больших объемов данных, улучшая возможности принятия решений за счет продвинутого анализа.

- Образование и учебные инструменты: Образователи могут создавать интерактивные учебные материалы, интегрируя LLM для предоставления мгновенной обратной связи или персонализированных образовательных маршрутов для студентов.

- Творческие приложения: Художники и создатели могут использовать LiteLLM для генерации новых идей, повышения креативности и исследования художественных направлений в музыке, литературе и визуальных искусствах.

Как использовать Berri?

Чтобы начать работу с LiteLLM, выполните следующие шаги:

- Установите LiteLLM: Скачайте и установите LiteLLM через официальный репозиторий или Docker.

- Создайте аккаунт: Зарегистрируйтесь на платформе LiteLLM, чтобы получить доступ и получить API-ключи.

- Настройте провайдеров: Выберите предпочитаемые провайдеры LLM и настройте их через панель управления LiteLLM.

- Настройка балансировки нагрузки: Определите свои предпочтения по балансировке нагрузки для оптимизации распределения запросов.

- Реализуйте API-запросы: Используйте SDK LiteLLM для Python или прямые API-вызовы в своем коде приложения, чтобы начать использовать возможности LLM.

- Мониторинг использования: Отслеживайте расходы и использование через предоставленную панель аналитики, чтобы обеспечить оптимальную производительность и эффективность затрат.

Часто задаваемые вопросы о Berri:

В: Как LiteLLM управляет балансировкой нагрузки API?

О: LiteLLM интеллектуально распределяет входящие запросы между несколькими LLM, обеспечивая оптимальную производительность и предотвращая перегрузку любой отдельной модели.

В: Какие провайдеры LLM поддерживаются LiteLLM?

О: LiteLLM поддерживает широкий спектр провайдеров, включая OpenAI, Azure OpenAI, Vertex AI и Bedrock и других.

В: Является ли LiteLLM решением с открытым кодом и может ли он быть размещён на собственных серверах?

О: Да, LiteLLM является решением с открытым кодом, что позволяет пользователям размещать и модифицировать его в соответствии со своими требованиями.

В: Как я могу отслеживать свои расходы на LLM?

О: LiteLLM предоставляет инструменты отслеживания затрат, которые позволяют устанавливать бюджеты, мониторить использование и генерировать отчеты о расходах.

В: Могу ли я создавать виртуальные ключи для различных команд?

О: Абсолютно! LiteLLM позволяет вам создавать виртуальные ключи для различных команд или проектов, облегчая лучшее управление затратами и контроль доступа.