Berriとは何ですか?

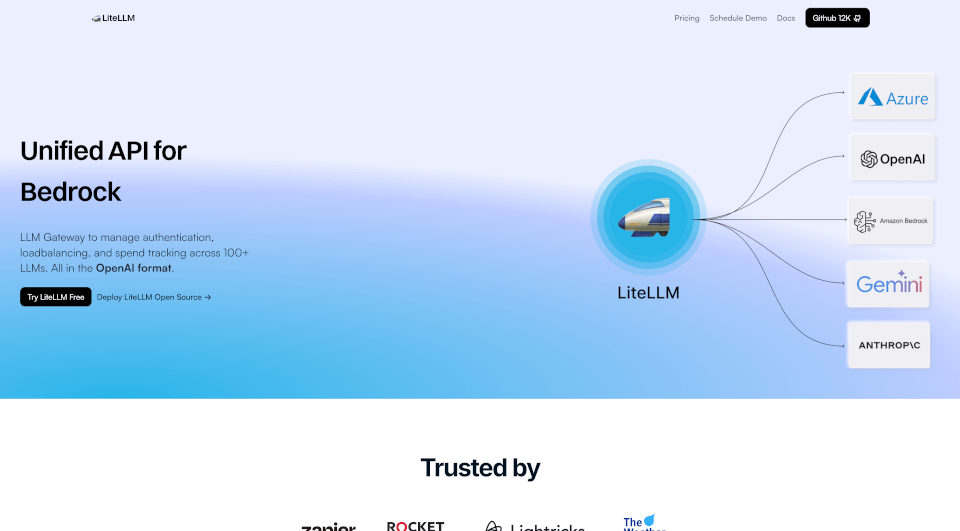

LiteLLMは、複数の言語学習モデル(LLM)の管理を統一APIを介して効率化するために設計された先進的なソリューションです。負荷分散、フォールバック、および支出追跡をサポートする機能を備えたLiteLLMは、効率を向上させ、OpenAI、Azure OpenAI、Vertex AI、Bedrockなど、100以上のLLMとシームレスに統合します。開発者、データサイエンティスト、AI愛好者を問わず、LiteLLMを使用すれば、最先端のLLMテクノロジーの力を簡単に活用できます。

Berriの特徴は何ですか?

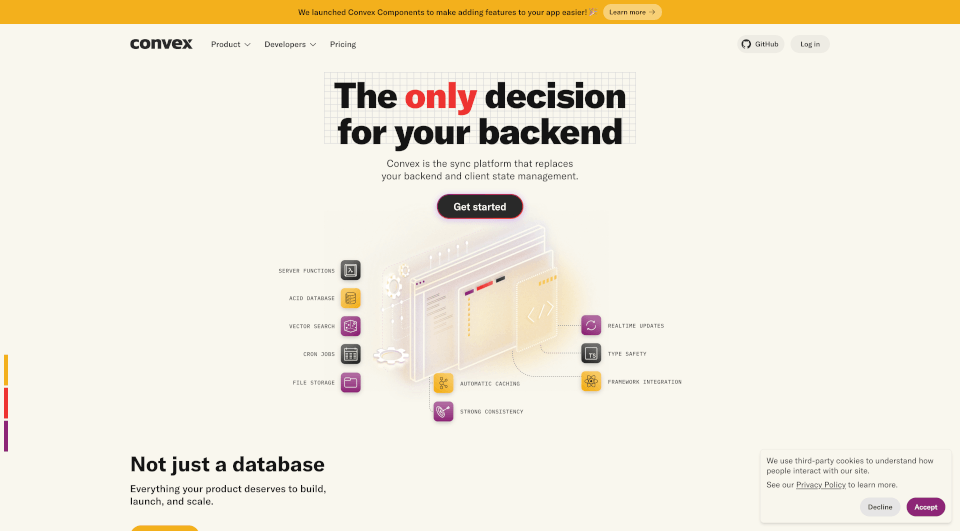

- 複数プロバイダーの統一API: LiteLLMは、さまざまなモデルを単一のAPIインターフェースに集約し、開発者が標準化された方法で複数のLLMと対話できるようにします。

- 負荷分散: この機能は、リクエストの分散を最適化し、特定のモデルへの過負荷を避けつつ、安定したパフォーマンスを確保します。

- フォールバックメカニズム: APIの障害が発生した場合、LiteLLMは自動的にリクエストを代替モデルにリダイレクトし、サービスの中断を防ぎます。

- 支出追跡: LLMに対する支出を正確に管理・監視できます。LiteLLMは予算を設定し、効果的に支出を追跡するためのツールを提供します。

- 仮想キーと予算: 異なるチームやプロジェクトのために仮想キーを生成し、特定の予算を割り当ててコストを効果的に管理します。

- 監視とログ記録: リクエストとパフォーマンスの継続的な監視は、Langfuse、Langsmith、およびOpenTelemetryとの統合により、詳細な分析とログ記録を可能にします。

- メトリクスと認証: JWT認証、シングルサインオン(SSO)、および監査ログをサポートして、セキュリティとコンプライアンスを向上させます。

- コミュニティとセットアップサポート: 200以上の貢献者と活況に満ちたコミュニティにより、LiteLLMのサポートは容易に利用でき、セットアッププロセスがスムーズで充実しています。

Berriの特性は何ですか?

LiteLLMは急速に進化するAIのランドスケープにおいて、その堅牢なアーキテクチャとユーザー中心の設計で特に際立っています。以下の特性を持ちます:

- 100%の稼働保証: 広範なインフラストラクチャサポートにより、ユーザーはLLMサービスへの途切れのないアクセスを確保できます。

- オープンソースの柔軟性: LiteLLMはオープンソースソリューションとして提供されているため、ユーザーはニーズに合わせて変更およびホスティングできます。これにより、適応性と革新が促進されます。

- 高需要の信頼性: Dockerからの90,000以上のプルリクエストと2000万件以上のリクエストが記録されており、LiteLLMの能力とコミュニティ内での信頼を示しています。

- シームレスな統合: シンプルでありながら強力な統一APIを提供することにより、LiteLLMはアプリケーションがさまざまなLLMに簡単に接続できるようにします。

Berriの使用例は何ですか?

LiteLLMは多用途であり、さまざまな領域で効果的に利用できます:

- コンテンツ生成: 企業はLiteLLMを使用して自動的に書面コンテンツ、ブログ、マーケティング資料、および製品説明を生成し、時間と労力を削減できます。

- 対話型エージェント: LiteLLMをチャットボットやバーチャルアシスタントに実装することで、さまざまなLLMからの洞察を引き出し、その応答性と正確性を向上させます。

- データ分析: 研究者やアナリストはLiteLLMを利用して膨大なデータを統合し、高度な分析を通じて意思決定能力を向上させることができます。

- 教育および学習ツール: 教育者は、LLMを統合して学生に即時フィードバックやパーソナライズされた学習パスを提供するインタラクティブな学習体験を作り出します。

- クリエイティブアプリケーション: アーティストやクリエイターは、LiteLLMを使用して新たなアイデアを生成し、創造性を向上させ、音楽、執筆、および視覚芸術の分野での芸術的な道を探求できます。

Berriの使い方は?

LiteLLMを始めるには、以下の手順に従ってください:

- LiteLLMのインストール: 公式リポジトリまたはDockerを通じてLiteLLMをダウンロードしてインストールします。

- アカウントの作成: LiteLLMプラットフォームにサインアップして、アクセス権を得てAPIキーを取得します。

- プロバイダーの設定: お好みのLLMプロバイダーを選び、LiteLLMダッシュボードから構成します。

- 負荷分散の設定: リクエスト分散を最適化するために負荷分散の設定を定義します。

- APIコールの実装: LiteLLMのPython SDKまたは直接APIコールを使って、アプリケーションコード内でLLM機能を利用し始めます。

- 使用状況の監視: 提供された分析ダッシュボードを通じて支出と使用状況を追跡し、最適なパフォーマンスとコスト効果を確保します。