O que é Berri?

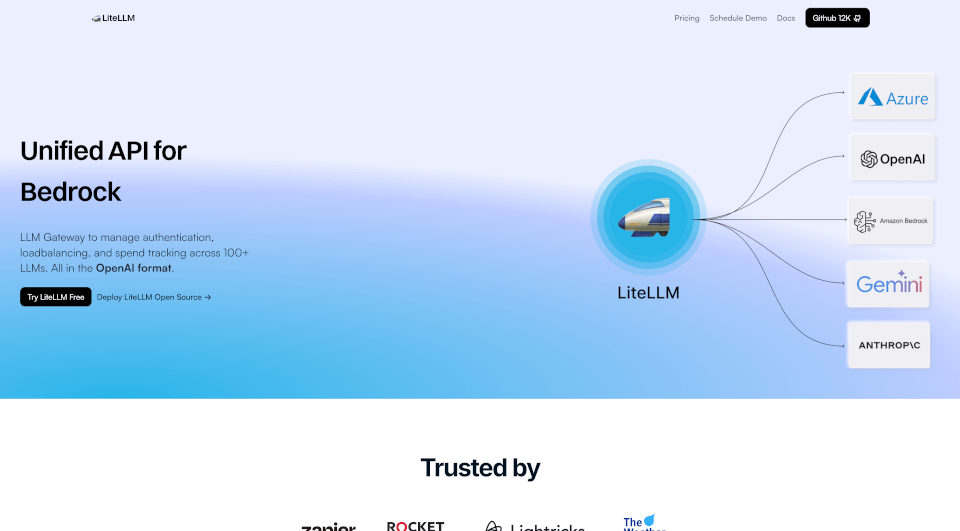

LiteLLM é uma solução avançada projetada para simplificar a gestão de múltiplos Modelos de Aprendizado de Linguagem (LLMs) através de uma API unificada. Com capacidades que suportam balanceamento de carga, mecanismos de fallback e monitoramento de gastos, o LiteLLM aumenta a eficiência e oferece uma integração perfeita com mais de 100 LLMs, incluindo provedores proeminentes como OpenAI, Azure OpenAI, Vertex AI e Bedrock. Seja você um desenvolvedor, cientista de dados ou entusiasta de IA, o LiteLLM torna fácil aproveitar o poder da tecnologia LLM de ponta sem a complexidade usual.

Quais são as características de Berri?

- API Unificada para Múltiplos Provedores: O LiteLLM agrega vários modelos em uma única interface de API, permitindo que os desenvolvedores interajam com múltiplos LLMs de maneira padronizada.

- Balanceamento de Carga: Este recurso otimiza a distribuição de requisições entre diferentes LLMs para garantir um desempenho uniforme e evitar sobrecarga em modelos específicos.

- Mecanismos de Fallback: No caso de uma falha de API, o LiteLLM redireciona automaticamente as requisições para modelos alternativos, garantindo um serviço ininterrupto.

- Monitoramento de Gastos: Gerencie e monitore suas despesas em LLMs com precisão. O LiteLLM oferece ferramentas para definir orçamentos e acompanhar gastos de forma eficaz.

- Chaves Virtuais e Orçamentos: Gere chaves virtuais para diferentes equipes ou projetos e aloque orçamentos específicos para gerenciar custos de forma eficiente.

- Monitoramento e Registro: O monitoramento contínuo de requisições e desempenho com integrações para Langfuse, Langsmith e OpenTelemetry permite uma análise e registro abrangentes.

- Métricas e Autenticação: Suporta autenticação JWT, single sign-on (SSO) e registro de auditoria para melhorar a segurança e a conformidade.

- Suporte da Comunidade e Configuração: Com mais de 200 colaboradores e uma comunidade ativa, o suporte para o LiteLLM está prontamente disponível, tornando o processo de configuração suave e produtivo.

Quais são as características de Berri?

O LiteLLM se destaca no cenário em rápida evolução da IA devido à sua arquitetura robusta e design centrado no usuário. Ele é caracterizado por:

- Garantia de 100% de Uptime: Com suporte de infraestrutura extensivo, os usuários podem contar com acesso ininterrupto aos serviços de LLM.

- Flexibilidade Open Source: O LiteLLM está disponível como uma solução de código aberto, o que significa que os usuários podem modificá-lo e hospedá-lo de acordo com suas necessidades, promovendo adaptabilidade e inovação.

- Confiabilidade em Alta Demanda: Mais de 90.000 downloads do Docker e mais de 20 milhões de requisições atendidas destacam a capacidade e confiança do LiteLLM dentro da comunidade.

- Integração Sem Costura: Ao fornecer uma API unificada simples, mas poderosa, o LiteLLM garante que suas aplicações possam facilmente se conectar a vários LLMs sem complicações.

Quais são os casos de uso de Berri?

O LiteLLM é versátil e pode ser utilizado de forma eficaz em vários domínios:

- Geração de Conteúdo: As empresas podem usar o LiteLLM para gerar automaticamente conteúdo escrito, blogs, materiais de marketing e descrições de produtos, reduzindo o tempo e esforço envolvidos.

- Agentes Conversacionais: Implementar o LiteLLM em chatbots ou assistentes virtuais aumenta sua capacidade de resposta e precisão ao extrair insights de diversos LLMs.

- Análise de Dados: Pesquisadores e analistas podem aproveitar o LiteLLM para sintetizar grandes quantidades de dados, melhorando as capacidades de tomada de decisão através de análises avançadas.

- Ferramentas de Aprendizado e Educação: Educadores podem criar experiências de aprendizado interativas ao integrar LLMs para fornecer feedback instantâneo ou caminhos de aprendizado personalizados para os alunos.

- Aplicações Criativas: Artistas e criadores podem usar o LiteLLM para gerar novas ideias, melhorar a criatividade e explorar avenidas artísticas em música, escrita e artes visuais.

Como usar Berri?

Para começar a usar o LiteLLM, siga estas etapas:

- Instale o LiteLLM: Faça o download e instale o LiteLLM através do repositório oficial ou Docker.

- Crie uma Conta: Inscreva-se na plataforma LiteLLM para obter acesso e suas chaves de API.

- Configure os Provedores: Escolha seus provedores LLM preferidos e configure-os através do painel do LiteLLM.

- Configure o Balanceamento de Carga: Defina suas preferências de balanceamento de carga para otimizar a distribuição de requisições.

- Implemente Chamadas de API: Use o SDK Python do LiteLLM ou chamadas diretas de API em seu código de aplicação para começar a aproveitar as capacidades dos LLMs.

- Monitore o Uso: Acompanhe gastos e uso através do painel de análise fornecido para garantir desempenho e custo-efetividade ideais.