¿Qué es Berri?

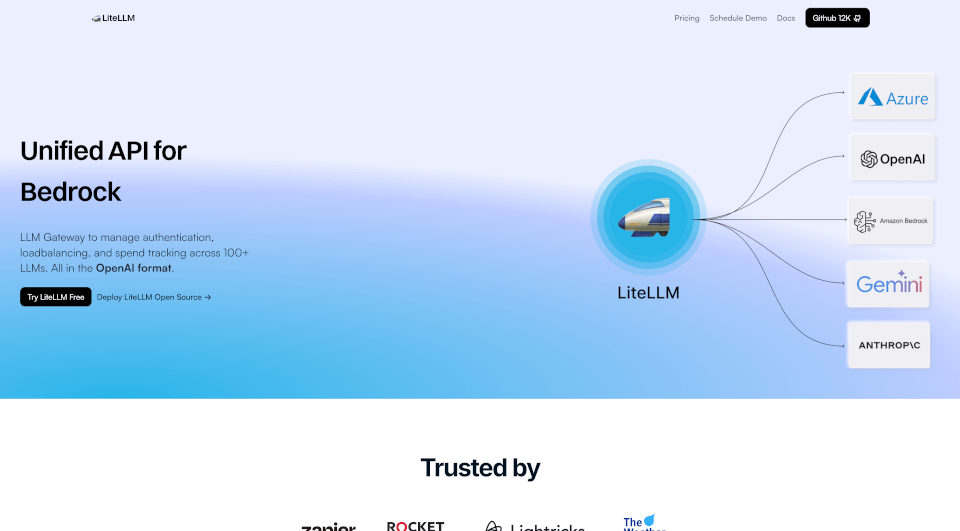

LiteLLM es una solución avanzada diseñada para optimizar la gestión de múltiples Modelos de Aprendizaje del Lenguaje (LLMs) a través de una API unificada. Con capacidades que soportan balanceo de carga, mecanismos de respaldo, y seguimiento de gastos, LiteLLM incrementa la eficiencia y ofrece integración sin problemas con más de 100+ LLMs, incluyendo proveedores destacados como OpenAI, Azure OpenAI, Vertex AI y Bedrock. Ya seas desarrollador, científico de datos o entusiasta de la IA, LiteLLM facilita el aprovechamiento del poder de la tecnología de LLM de última generación sin la complejidad habitual.

¿Cuáles son las características de Berri?

- API Unificada para Múltiples Proveedores: LiteLLM agrega varios modelos en una única interfaz de API, permitiendo a los desarrolladores interactuar con múltiples LLMs de manera estandarizada.

- Balanceo de Carga: Esta característica optimiza la distribución de solicitudes a través de diferentes LLMs para asegurar un rendimiento uniforme y evitar sobrecargas en modelos específicos.

- Mecanismos de Respaldo: En caso de un fallo en la API, LiteLLM redirige automáticamente las solicitudes a modelos alternativos, asegurando un servicio ininterrumpido.

- Seguimiento de Gastos: Gestiona y monitorea tu gasto en LLMs con precisión. LiteLLM ofrece herramientas para establecer presupuestos y rastrear gastos de manera efectiva.

- Claves Virtuales y Presupuestos: Genera claves virtuales para diferentes equipos o proyectos y asigna presupuestos específicos para gestionar costes de manera efectiva.

- Monitoreo y Registro: El monitoreo continuo de solicitudes y rendimiento, con integraciones para Langfuse, Langsmith y OpenTelemetry, permite un análisis y registro exhaustivos.

- Métricas y Autenticación: Soporta autenticación JWT, inicio de sesión único (SSO) y registro de auditoría para mejorar la seguridad y el cumplimiento.

- Comunidad y Soporte de Configuración: Con más de 200 contribuyentes y una comunidad floreciente, el soporte para LiteLLM está fácilmente disponible, facilitando el proceso de configuración.

¿Cuáles son las características de Berri?

LiteLLM se destaca en el paisaje de IA en rápida evolución debido a su arquitectura robusta y diseño centrado en el usuario. Se caracteriza por:

- Garantía de 100% de Tiempo de Actividad: Con un soporte de infraestructura extenso, los usuarios pueden confiar en un acceso ininterrumpido a los servicios de LLM.

- Flexibilidad de Código Abierto: LiteLLM está disponible como solución de código abierto, lo que significa que los usuarios pueden modificarlo y alojarlo según sus necesidades, promoviendo la adaptabilidad y la innovación.

- Confiabilidad en Alta Demanda: Más de 90,000 descargas desde Docker y más de 20 millones de solicitudes atendidas destacan la capacidad y confianza de LiteLLM dentro de la comunidad.

- Integración Sin Problemas: Al proporcionar una API unificada simple pero poderosa, LiteLLM asegura que tus aplicaciones puedan conectarse fácilmente a varios LLMs sin complicaciones.

¿Cuáles son los casos de uso de Berri?

LiteLLM es versátil y puede ser utilizado de manera efectiva en múltiples dominios:

- Generación de Contenido: Las empresas pueden usar LiteLLM para generar automáticamente contenido escrito, blogs, materiales de marketing y descripciones de productos, reduciendo el tiempo y el esfuerzo involucrados.

- Agentes Conversacionales: Implementar LiteLLM en chatbots o asistentes virtuales mejora su capacidad de respuesta y precisión al obtener información de varios LLMs.

- Análisis de Datos: Investigadores y analistas pueden aprovechar LiteLLM para sintetizar grandes volúmenes de datos, mejorando las capacidades de toma de decisiones mediante un análisis avanzado.

- Herramientas Educativas y de Aprendizaje: Los educadores pueden crear experiencias de aprendizaje interactivas integrando LLMs para proporcionar retroalimentación instantánea o rutas de aprendizaje personalizadas para los estudiantes.

- Aplicaciones Creativas: Artistas y creadores pueden utilizar LiteLLM para generar nuevas ideas, mejorar la creatividad y explorar avenidas artísticas en música, escritura y artes visuales.

¿Cómo usar Berri?

Para comenzar con LiteLLM, sigue estos pasos:

- Instala LiteLLM: Descarga e instala LiteLLM a través del repositorio oficial o de Docker.

- Crea una Cuenta: Regístrate en la plataforma LiteLLM para obtener acceso y obtener claves de API.

- Configura los Proveedores: Elige tus proveedores de LLM preferidos y configúralos a través del panel de control de LiteLLM.

- Configura el Balanceo de Carga: Define tus preferencias de balanceo de carga para optimizar la distribución de solicitudes.

- Implementa Llamadas a la API: Usa el SDK de Python de LiteLLM o las llamadas directas a la API en tu código de aplicación para comenzar a aprovechar las capacidades de LLM.

- Monitorea el Uso: Rastrea el gasto y el uso a través del panel de análisis proporcionado para asegurar un rendimiento óptimo y efectividad en costes.