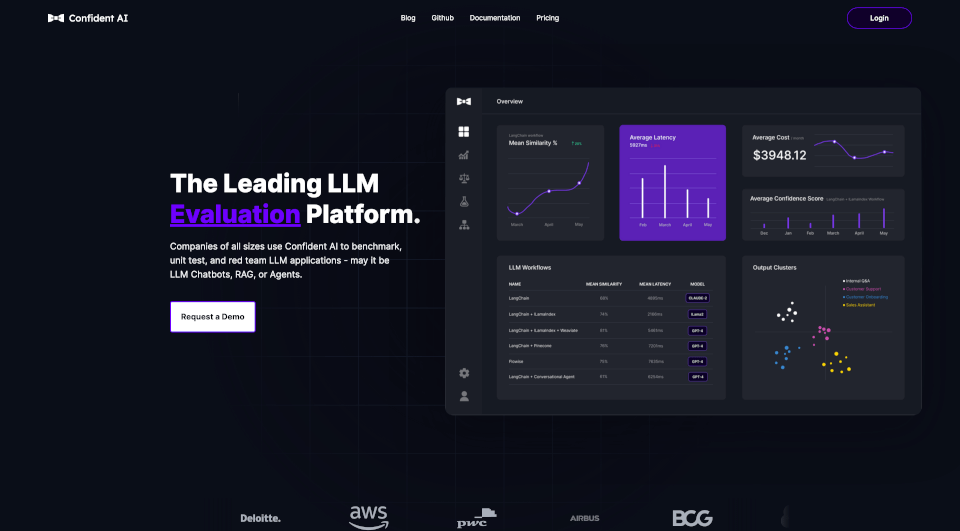

Confident AIとは何ですか?

Confident AIは、大規模言語モデル(LLM)アプリケーションのパフォーマンスをベンチマークし定量化するために設計された、業界最先端のオールインワンプラットフォームです。企業はカスタムLLMメトリクスをシームレスに実装できる強力なソリューションを提供し、全ての規模の企業に対応しています。LLMチャットボット、リトリーバル拡張生成(RAG)、およびさまざまなエージェントのパフォーマンスを向上させることに重点を置いているConfident AIは、AIシステムを効果的に評価し、LLMソリューションを自信を持って展開する力をチームに与えます。

Confident AIの特徴は何ですか?

自動回帰検出: Confident AIのプラットフォームでは、ユーザーがLLMシステムの回帰を自動的に検出できます。ユニットテスト機能を使用してテスト結果を比較し、パフォーマンスのドリフトを検出し、回帰の根本原因を特定します。これにより、さまざまなアプリケーションでLLMの一貫した信頼性のあるパフォーマンスが保証されます。

研究に基づいた評価メトリクスとDeepEval: DeepEvalによって提供される評価メトリクスは、LLMシステムを評価するための研究に基づいた指標を提供します。これらのメトリクスは、人間の評価に匹敵する精度と信頼性を提供し、RAG、エージェント、チャットボットなど、さまざまなLLMシステムをカバーします。

高度なLLM可観測性: 企業は、プロンプトテンプレートやモデル構成を含むさまざまなハイパーパラメータのA/Bテストを簡単に行えます。このリアルタイムフィードバックにより、ユーザーは様々な構成下でのLLMシステムのパフォーマンスを監視し、最終的により良い意思決定と最適化が可能になります。

カスタマイズされた合成データセット生成: Confident AIは、各顧客のLLM評価ニーズに特化した合成データセットの生成を可能にします。これらのデータセットは、クライアントの知識ベースに従って設計され、さまざまな出力形式にカスタマイズされるため、関連性と精度が保証されます。

自動LLMレッドチーミング: このプラットフォームは、自動化されたレッドチーミング機能を備えており、LLMアプリケーションの安全リスクを特定するのに役立ちます。さまざまなハイパーパラメータの最も効果的な組み合わせを発見することで、ユーザーはアプリケーションの安全性と効果を最適化できます。

Confident AIの特性は何ですか?

- ユーザーフレンドリーなAPI: Confident AIは、評価やモニタリングのためにLLMシステムとシームレスに統合できるユーザーフレンドリーなAPIを提供します。

- モニタリングとレポーティングダッシュボード: プラットフォームには、パフォーマンスを詳しく報告し分析するための強力なダッシュボードが含まれており、ユーザーがパフォーマンスを追跡し、改善点を特定するのに役立ちます。

- グラウンドトゥルースの定義: ユーザーは、LLMの出力を期待される結果と比較するためのグラウンドトゥルースを定義できるため、より良い評価を促進し、反復が必要な領域を特定できます。

- Diffトラッキング: 高度なdiffトラッキング機能により、プロンプトテンプレートを調整したり、アプリケーションに適した知識ベースを選択したりする過程で、ユーザーは逐次的な改善が可能になります。

- 効率的な展開: Confident AIを使用することで、開発から本番環境への移行時間が2.4倍短縮され、LLMソリューションの展開の効率が向上します。

Confident AIの使用例は何ですか?

Confident AIは多用途で、さまざまなシナリオで適用できます:

- チャットボット: 徹底した評価を通じて会話AIを強化し、応答を最適化し、関連性を確保します。

- リトリーバル拡張生成(RAG): 外部知識源を活用して応答やインタラクションを豊かにするシステムを改善します。

- AIエージェント: 詳細なパフォーマンス分析を通じて、特定のタスクや操作向けにAI駆動のエージェントを最適化します。

- カスタマーサポート: 改善されたチャットボットの応答と低遅延を通じて、サポート業務を効率化します。

- マーケティングキャンペーン: LLM技術を使用して、キャンペーン向けの魅力的かつターゲットを絞ったコンテンツを生成します。

Confident AIの使い方は?

Confident AIを始めるには:

- アカウントを作成: Confident AIプラットフォームにサインアップします。

- ツールとの統合: 既存のツールやプラットフォームと接続して、LLMの機能を活用します。

- 評価を実行: Pythonでテストケースを書き、DeepEvalフレームワークを利用して正確な評価を実行します。

from deepeval import confident_evaluate

test_case = LLMTestCase(input="...", actual_output="...")

confident_evaluate(experiment_name="RAG Test", test_cases=[test_case])

必要なパッケージは以下のコマンドでインストールできます:

pip install -U deepeval

評価のセットアップが完了したら、テストを実行してLLMパフォーマンスを監視し始めます。